TT-Forge™

TT-Forge™はTenstorrentのMLIRベースのコンパイラーで、ドメイン固有のコンパイラーからカスタム・カーネル・ジェネレーターまで、様々なMLフレームワークで動作するように設計されています。

TT-Forge™ は、Tenstorrent の既存の AI ソフトウェア・エコシステムとネイティブに統合されているため、簡単に構築できます。

革新のために設計された

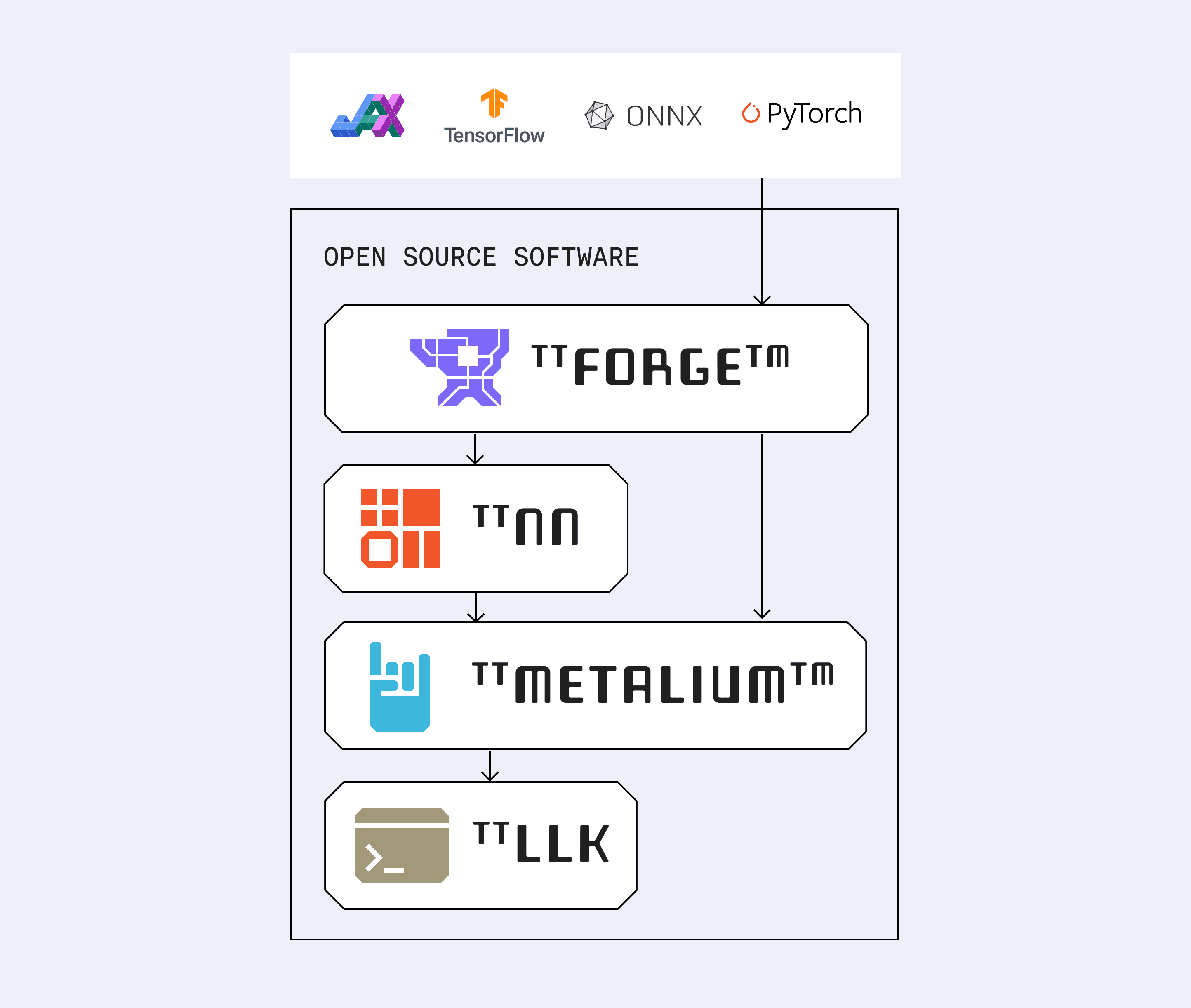

オープンソースの柔軟性を念頭に設計されたTT-Forgeは、OpenXLA、MLIR、ONNX、TVM、PyTorch、TensorFlowと連携します。TT-Forgeは、カスタムシリコン上でAIワークロードを推進するためのモジュラーな基盤を提供します。モデルを最適化されたIRに落とし込み、TT-NNおよびTT-Metalium(Tenstorrentの低レベルAIハードウェアSDK)上で実行できるようにします。

なぜMLIRなのか?

MLIRはモジュール式で拡張可能で、マルチレベルの抽象化を可能にします。複数のフレームワークにまたがり、カスタム方言をサポートし、AIからHPCまで幅広く対応します。MLIRの柔軟な設計のおかげで、TT-Forgeは新しいオペレーション、フレームワーク、ハードウェアターゲットを素早く取り入れられます。MLIRのエコシステムが拡大するにつれて、TT-Forgeもそれと歩調を合わせて進化します。

TT-XLA

JAXとPyTorchを使ったシングルチップのプロジェクト

TT-XLA is Tenstorrent’s PJRT-based bridge for compiling and running models from JAX and PyTorch on Tenstorrent hardware. It supports just-in-time (JIT) compilation through StableHLO, feeding into TT-MLIR for optimized execution.

With native support in JAX and integration through PyTorch/XLA, TT-XLA compiles models to run on Tenstorrent hardware—with minimal changes to your existing code and support for multi-chip execution.

TT-Forge-FE

ONNX と TensorFlow を用いたマルチチップ・プロジェクト

TT-Forge-FE は、ディープラーニングモデルの計算グラフを最適化・変換するために設計された、Tenstorrent のフレームワーク非依存のフロントエンドです。TT-TVM を基盤としており、ONNX や TensorFlow などの機械学習フレームワークの取り込みに対応しているため、モデルを Tenstorrent のハードウェアに効率的に移行しやすくなります。