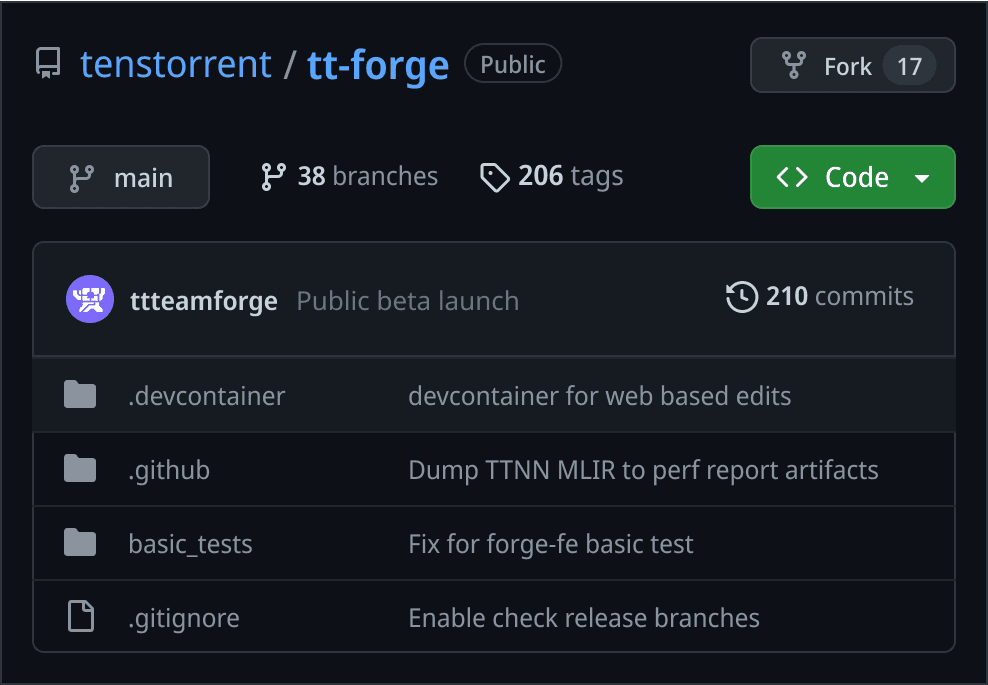

TT-Forge™

TT-Forge는 모델의 컴파일, 최적화, 디버깅 및 확장을 지원하는 Tenstorrent의 MLIR 기반 컴파일러 스택입니다. 현재 퍼블릭 베타 버전인 TT-Forge는 여러분이 직접 만들어가는 공간입니다. 새로운 기능을 제안하거나, 프로토타입을 제작하거나, 바운티(현상금) 프로그램에 참여해 보세요.

혁신을 위한 설계

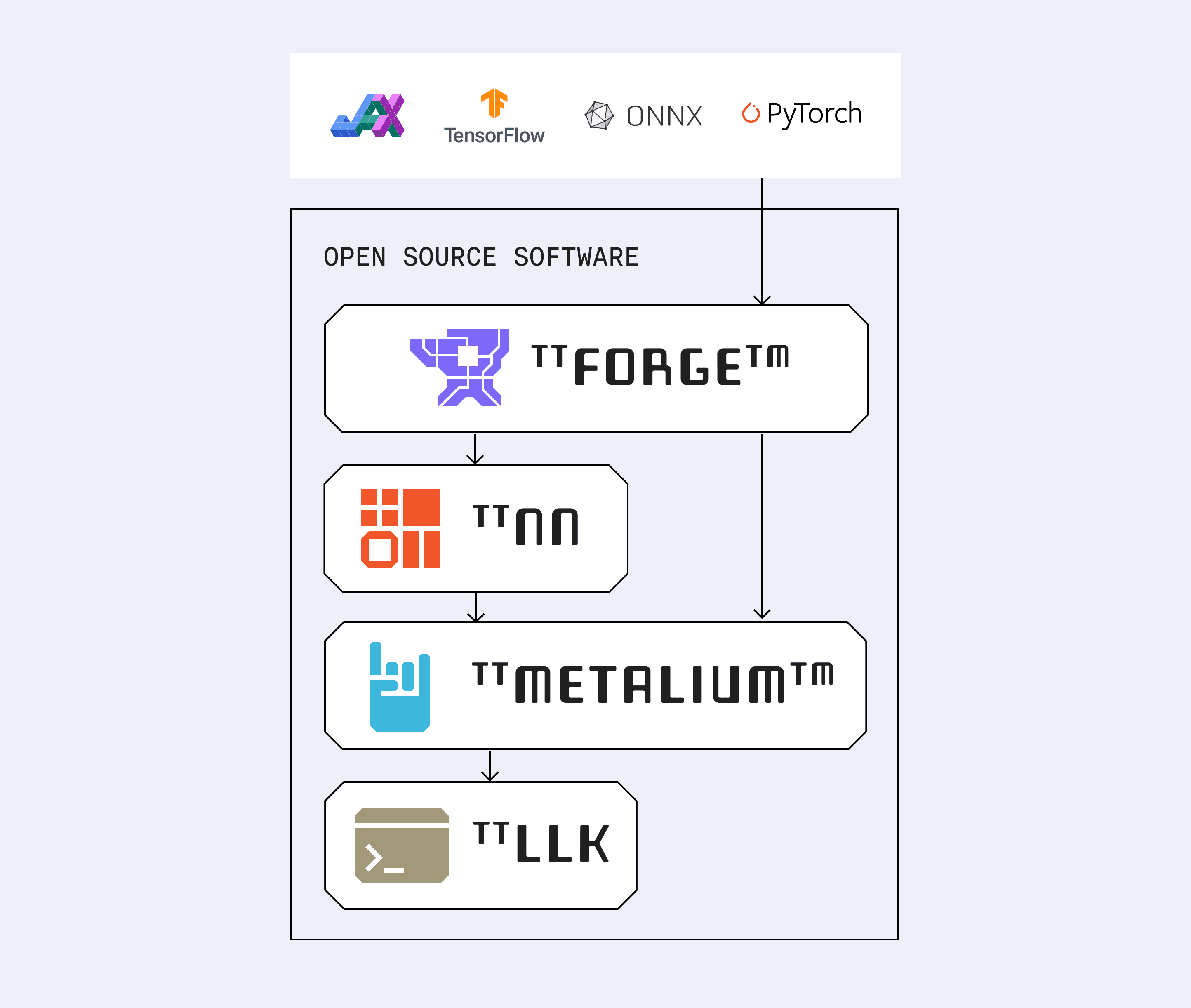

오픈 소스의 유연성을 위해 설계된 TT-Forge는 OpenXLA, MLIR, ONNX, TVM, PyTorch 및 TensorFlow와 연결됩니다. TT-Forge는 커스텀 실리콘에서 AI 워크로드를 구동하기 위한 모듈형 기반을 제공합니다. 또한 모델을 최적화된 IR로 변환하여 텐스토렌트(Tenstorrent)의 저수준 AI 하드웨어 SDK인 TT-NN 및 TT-Metalium에서 실행할 수 있도록 합니다.

왜 MLIR인가요?

MLIR은 모듈식이며 확장 가능하고 다단계 추상화를 지원합니다. 여러 프레임워크를 아우르며 사용자 정의 다이얼렉트를 지원하고, AI부터 HPC까지 모든 것을 처리합니다. MLIR의 유연한 설계 덕분에 TT-Forge는 새로운 연산(ops), 프레임워크 및 하드웨어 타겟을 신속하게 도입할 수 있습니다. MLIR 생태계가 확장됨에 따라 TT-Forge도 그와 함께 진화하고 있습니다.

TT-XLA

JAX 및 PyTorch를 이용한 단일 칩 프로젝트

TT-XLA는 JAX 및 PyTorch 모델을 Tenstorrent 하드웨어에서 컴파일하고 실행하기 위한 Tenstorrent의 PJRT 기반 브릿지입니다. 이는 StableHLO를 통한 적시(JIT) 컴파일을 지원하여 TT로 전달됩니다.

JAX의 네이티브 지원과 PyTorch/XLA를 통한 통합을 통해, TT-XLA는 기존 코드의 변경을 최소화하면서 모델을 Tenstorrent 하드웨어에서 실행할 수 있도록 컴파일하며, 멀티 칩 실행 기능도 지원합니다.

TT-Forge-FE

ONNX 및 TensorFlow를 활용한 멀티칩 프로젝트

TT-Forge-FE는 딥러닝 모델의 연산 그래프를 최적화하고 변환하기 위해 설계된 Tenstorrent의 프레임워크 독립형 프론트엔드입니다. TT-TVM을 기반으로 ONNX, TensorFlow 및 유사한 ML 프레임워크의 인입을 지원하여, 사용자의 모델을 Tenstorrent 하드웨어에 효율적으로 이식할 수 있도록 돕습니다.